هوش مصنوعی با کارت NVIDIA L40S و مقایسه آن با NVIDIA A100

با سرعت گرفتن انقلاب هوش مصنوعی، کسبوکارها به دنبال فناوریهای پیشرفته هستند تا پیشرو بمانند. همکاری بین NVIDIA و Supermicro منجر به تولید پلتفرم NVIDIA L40S شده است، یک GPU که برای انجام طیف گستردهای از کارها از هوش مصنوعی تا گرافیک طراحی شده است. این فناوری جدید وعده میدهد که مراکز داده را متحول کند و عملکرد و انعطافپذیری بیسابقهای را فراهم کند.

چالشهای مرکز داده هوش مصنوعی مدرن

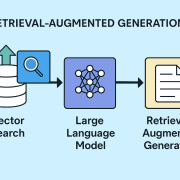

مراکز داده مدرن باید برای چندین کار بهینه شوند، از جمله آموزش و استنتاج هوش مصنوعی، رندر گرافیک و مجازیسازی. پلتفرم L40S این نیازها را با یک استک نرمافزاری بهینه شده، شبکهسازی با عملکرد بالا و معماری مقیاسپذیر برطرف میکند. این سازگاری تضمین میکند که مراکز داده میتوانند با رشد سریع در پذیرش هوش مصنوعی و ادغام مدلهای زبانی بزرگ (LLM) در برنامههای مختلف، همگام شوند.

NVIDIA L40S: GPU

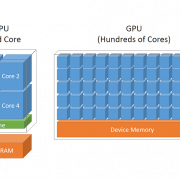

NVIDIA L40S به عنوان یک GPU قدرتمند و همهکاره که برای تسریع کارهای هوش مصنوعی و گرافیک طراحی شده است، برجسته است. ویژگیهای کلیدی شامل موارد زیر است:

- هستههای Tensor نسل چهارم: بهبود آموزش و استنتاج هوش مصنوعی با پشتیبانی از دقت FP8.

- RTX نسل سوم و DLSS 3: پشتیبانی از گرافیک و رندر با وضوح بالا با حافظه GPU 48 گیگابایتی.

- Omniverse Enterprise: تسهیل جریانهای کاری دیجیتال صنعتی 3D با استفاده از Universal Scene Description (OpenUSD).

- پخش و محتوای ویدئویی: تراکم کدگذاری/رمزگشایی بالاتر و پشتیبانی از AV1 برای بهبود خدمات ویدئویی.

مقایسه عملکرد: L40S در مقابل A100

NVIDIA L40S عملکرد به مراتب بهتری نسبت به GPU های قبلی HGX A100 ارائه میدهد. جدول زیر بهبود عملکرد را نشان میدهند:

| عملکرد L40S (نسبت به A100) | |

|---|---|

| آموزش RN50 | 1.7x |

| آموزش BERT-Large | 1.6x |

| استنتاج RN50 | 1.3x |

| استنتاج BERT-Large | 1.2x |

| DLRM | 1.4x |

| تنظیم دقیق GPT-40B LoRA (8 GPU) | 1.7x |

| تنظیم دقیق GPT-175B LoRA (64 GPU) | 1.6x |

| آموزش مدل کوچک GPT-7B (8 GPU) | 1.3x |

| آموزش مدل کوچک GPT-13B (8 GPU) | 1.2x |

| آموزش مدل بنیادی GPT-175B (256 GPU) | 1.4x |

علاوه بر عملکرد های فوق ، L40S همچنین از لحاظ قیمت هزینه به کارایی بهتری ارائه میدهد و این کارت را به گزینهای مقرونبهصرفه برای مراکز داده تبدیل میکند. در اینجا معیارهای عملکرد به ازای هر دلار آمده است:

| عملکرد L40S/$ (نسبت به A100) | |

|---|---|

| آموزش RN50 | 2.5x |

| آموزش BERT-Large | 2.4x |

| استنتاج RN50 | 1.9x |

| استنتاج BERT-Large | 1.8x |

| DLRM | 2.1x |

| تنظیم دقیق GPT-40B LoRA (8 GPU) | 2.5x |

| تنظیم دقیق GPT-175B LoRA (64 GPU) | 2.4x |

| آموزش مدل کوچک GPT-7B (8 GPU) | 1.9x |

| آموزش مدل کوچک GPT-13B (8 GPU) | 1.8x |

| آموزش مدل بنیادی GPT-175B (256 GPU) | 2.1x |

هزینه کارایی

نه تنها L40S در عملکرد برتری دارد، بلکه صرفهجویی قابل توجهی در هزینهها نیز ارائه میدهد. در مقایسه با HGX A100، L40S تا 2.5 برابر بهبود عملکرد. این باعث میشود که گزینهای جذاب برای سازمانهایی باشد که به دنبال حداکثر بازده سرمایهگذاری خود در زیرساختهای هوش مصنوعی هستند.

مقایسه ویژگیها و عملکرد L40S و A100

جدول زیر مقایسهای بین GPUهای L40S و A100 را نشان میدهد و ویژگیها و عملکردهای کلیدی هر یک را برجسته میکند:

| ویژگی | A100 80GB SXM | L40S |

|---|---|---|

| بهترین برای | عملکرد چند گرهای AI | GPU جهانی برای هوش مصنوعی |

| معماری GPU | NVIDIA Ampere | NVIDIA Ada Lovelace |

| FP64 | 9.7 TFLOPS | N/A |

| FP32 | 19.5 TFLOPS | 91.6 TFLOPS (افزایش 5 برابری) |

| هسته Tensor TF32* | 312 TFLOPS | 366 TFLOPS |

| هسته Tensor FP16/BF16* | 624 TFLOPS | 733 TFLOPS |

| هسته Tensor FP8* | N/A | 1466 TFLOPS (پشتیبانی از GenAI، آموزش و استنتاج LLM) |

| هسته Tensor INT8* | 1248 TOPS | 1466 TOPS |

| هسته RT | N/A | 212 TFLOPS (پشتیبانی از Ray Tracing برای رندر و گرافیک، DLSS3.0 برای تولید فریم AI و SER) |

| حافظه GPU | 80 GB HBM2e | 48 GB GDDR6 |

| پهنای باند حافظه GPU | 2039 GB/s | 864 GB/s |

| حافظه L2 | 40 MB | 96 MB (افزایش حافظه L2) |

| موتورهای رسانه | 0 NVENC، 5 NVDEC، 5 NVJPEG | 3 NVENC (+AV1)، 3 NVDEC، 4 NVJPEG (پشتیبانی از AV1 برای فشردهسازی و پخش ویدئو) |

| توان | تا 400 W | تا 350 W (حداکثر عملکرد) |

| فرم فاکتور | 8-way HGX | 2-slot FHFL |

| ارتباطات | PCIe Gen4 x16: 64 GB/s | PCIe Gen4 x16: 64 GB/s |

| در دسترس بودن | زمان تحویل طولانیتر | تولید (زمان تحویل کوتاهتر) |

پلتفرم L40S بهبودهای چشمگیری را در عملکرد و ویژگیها نسبت به A100 ارائه میدهد که آن را به گزینهای ایدهآل برای تسریع هوش مصنوعی مولد، آموزش LLM، استنتاج، Omniverse و رندر تبدیل میکند.

معماری بهینهشده برای کارهای AI Enterprise و Omniverse

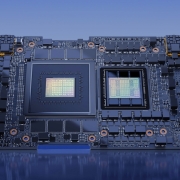

پلتفرم L40S انویدیا بهینهسازی شده برای کارهای سازمانی هوش مصنوعی و Omniverse با پیکربندی سرور 2-4-3 طراحی شده است. این پیکربندی شامل گزینههای زیر است:

- پردازندهها: شامل 2 پردازنده 32 هستهای Intel Xeon Gold 6448Y یا 2 پردازنده 32 هستهای AMD EPYC 9354.

- GPUها: 4 عدد GPU NVIDIA L40S برای گرافیک و محاسبات.

- آداپتورهای شبکه: 2 عدد ConnectX-7 برای ارتباطات GPU به GPU (“شرق-غرب”) و 1 عدد BlueField-3 برای مدیریت، ذخیرهسازی و امنیت (“شمال-جنوب”).

- حافظه میزبان: حداقل 384 گیگابایت حافظه کل با یک DIMM در هر کانال.

- درایو بوت میزبان: 1 درایو NVMe با ظرفیت 2 ترابایت.

- ذخیرهسازی میزبان: 2 درایو NVMe با ظرفیت 4 ترابایت.

این معماری بهینهسازی شده، به همراه نرمافزارهای تنظیم شده توسط انویدیا، تضمین میکند که سیستمها با حداکثر کارایی برای کارهای پیچیده هوش مصنوعی و Omniverse عمل میکنند.

سرور هوش مصنوعی با چهار L40S با امکان اتصال به یکدیگر

دیدگاه خود را ثبت کنید

تمایل دارید در گفتگوها شرکت کنید؟در گفتگو ها شرکت کنید.