تراشه جدید CPU + GPU غول پیکر انویدیا، ممکن است نسل بعدی چتبات های هوش مصنوعی

قدرت محاسباتی زیادی لازم است تا وانمود کنید انسان هستید.

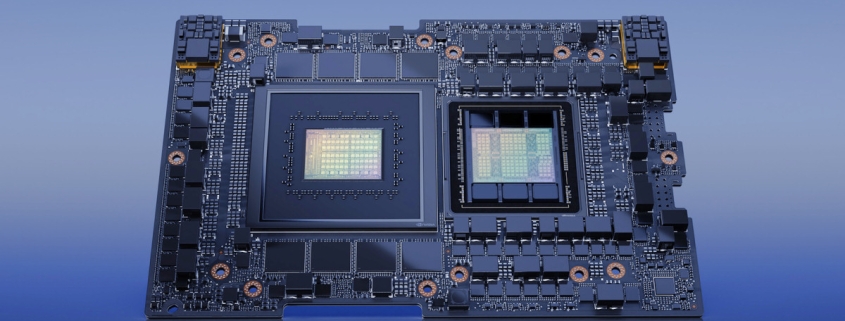

در ابتدای هفته گذشته در همایش COMPUTEX، شرکت انویدیا اعلام کرد که ابر تراشه جدید GH200 Grace Hopper خود، که ترکیب خاصی از CPU و GPU برای برنامه های هوش مصنوعی در مقیاس بزرگ ایجاد شده است را وارد مرحله تولید کرده. این تراشه دارای 528 هسته تنسور GPU است. از اتصال 480GB حافظه CPU و 96GB حافظه GPU پشتیبانی می کند و پهنای باند حافظه GPU تا 4TB در ثانیه میباشد.

قدرتمندترین GPU مرکز داده Nvidia تراشههای Hopper H100 Nvidia است که در حال حاظر توسط هوش مصنوعی هایی مانندChatGPT از آن استفاده می کنند. این تراشه ارتقای مهمی را نسبت به تراشه A100 تولید شده در سال 2020 بود. این تراشه مورد استفاده دور اول اجرای آموزشی بسیاری از Chatbot ها و هوش مصنوعی های تولید کننده تصاویر امروز که در خصوص آنها صحبت می کنیم، میباشد.

GPU های سریع تر باعث تولید مدل های generative AI قدرتمندتر می شوند زیرا توانایی اجرای ضرب ماتریسی بیشتری (که برای شبکه های عصبی مصنوعی امروزی ضروری) را به صورت موازی دارند.

GH200 از پلتفرم سری Hopper تراشه های شرکت انویدیا استفاده میکند و آن را با پلتفرم تراشه های CPU انویدیا به نام “Grace” (که هر دو اسم به نام یکی از بمتکران صنعت کامپیوتر Grace Hopper نامگذاری شدهاند) را ترکیب می کند. در این تراشه جدید بخش CPU و GPU از طریق فناوری اتصال تراشه به تراشه(C2C) NVLink Nvidia به یک دیگر متصل می شوند. انویدیا انتظار دارد که این ترکیب به طور چشمگیری برنامه های هوش مصنوعی و یادگیری ماشین را در هر دو بخش آموزش (ایجاد یک مدل) و استنتاج (اجرای ان) تسریع کند.

Generative AI به سرعت در حال تغییر کسب و کار ها، ایجاد فرصت های جدید و تسریع اکتشافات صنعت درمان، امور مالی، خدمات کسب و کار و بسیاری دیگر از صنایع می باشد. در یک گزارش مطبوعاتی از شرکت انویدیا، آقای ایان باک، معاون بخش محاسبات سریع انویدیا می گوید «با رسیدن ابر تراشه Grace Hopper به تولید انبوه، شرکت های تولید کننده در سراسر جهان به زودی زیرساختی محاسباتی مورد نیاز برای ساخت و استقرار برنامه های کاربردی generative AI را فراهم می کند.”

به گفته انویدیا، ویژگی های کلیدی GH200 شامل یک رابط حافظه منسجم (مشترک) جدید 900 گیگابایت بر ثانیه است که هفت برابر سریعتر از PCIe Gen5 است. GH200 همچنین 30 برابر پهنای باند تجمیعی حافظه سیستم را به GPU در مقایسه با Nvidia DGX A100 ارائه می دهد. علاوه بر این، GH200 می تواند تمام سیستم عامل های نرم افزاری Nvidia، از جمله Nvidia HPC SDK، Nvidia AI و Nvidia Omniverse را اجرا کند.

انویدیا همچنین اعلام کرد که این تراشه CPU / GPU را بر روی یک ابر رایانه جدید به نام DGX GH200 پیاده سازی خواهد کرد. این ابر رایانه می تواند از قدرت ترکیبی 256 تراشه GH200 بصورت یک پارچه استفاده کند و 144 ترابایت حافظه مشترک ارائه دهد، تقریبا 500 برابر حافظه بیشتر از نسل قبلی Nvidia DGX A100.

DGX GH200 قادر به آموزش نسل بعدی مدل های هوش مصنوعی غول پیکر (مثلا GPT-6) برای برنامه های کاربردی Generative AI، سیستم های توصیه کننده و تجزیه و تحلیل داده ها خواهد بود. انویدیا قیمت GH200 را اعلام نکرده، اما طبق گفته Anandtech، یک کامپیوتر DGX GH200 چند ده میلیون دلار قیمت خواهد داشت.

به طور کلی، منطقی است که بگوییم به لطف پیشرفت های سخت افزاری مداوم از فروشندگان مانند Nvidia و Cerebras، مدل های هوش مصنوعی ابری با کیفیت بالا احتمالا در طول زمان توانمندتر خواهند شد، داده های بیشتری را پردازش می کنند و این کار را بسیار سریعتر از قبل انجام خواهند داد.

دیدگاه خود را ثبت کنید

تمایل دارید در گفتگوها شرکت کنید؟در گفتگو ها شرکت کنید.