محاسبات هوش مصنوعی و یادگیری عمیق

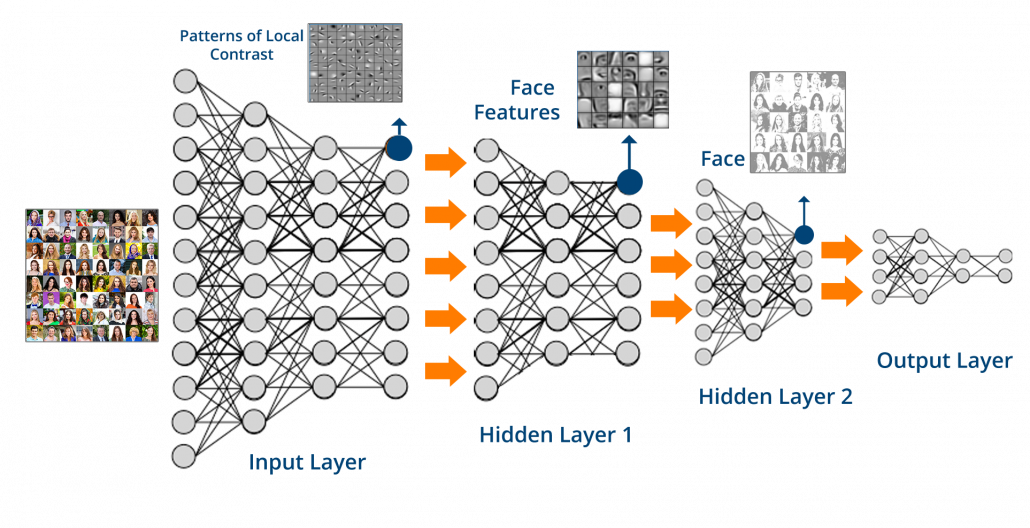

شرکتهای پیشرو حجمهای بسیار بالایی از داده را تجمیع میکنند و با بهرهگیری از تکنیکهای هوش مصنوعی و یادگیری ماشین AI/ML برای تحقق مزیت رقابتی، تلاش میکنند. از کاربردهای رایج این زیرساختها میتوان به پردازش تصوی (vision)، تشخیص تقلب (fraud detection) در تراکنشها، پیشبینی تقاضا (demand forecasting)، پیشبینی نرخ کلیک (click prediction) و تحلیلهای پیشرفته اشاره کرد. اما با ظهور یادگیری عمیق و بهویژه مدلهای زبان بزرگ (LLM)، سازمانها اکنون میتوانند قابلیتهایی مانند تولید خودکار متن، خلاصهسازی مستندات، تحلیل احساسات بهصورت بلادرنگ و چتباتهای هوشمند را در سطح محصول و خدمات خود ادغام کنند. علاوه بر این، با استفاده از معماری RAG (بازیابی-تولید ترکیبی)، این سیستمها قادرند اطلاعات دقیق و مبتنی بر منابع داخلی یا خارجی را در پاسخهای خود ادغام کرده و دقت و اتکاپذیری خروجیها را بهطور چشمگیری افزایش دهند.

چالش زیرساخت: پیادهسازی یادگیری عمیق در مقیاس سازمانی

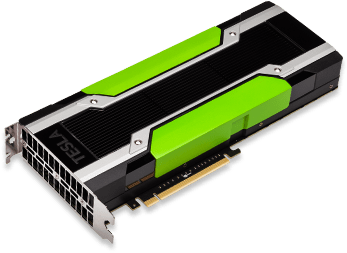

استقرار مؤثر مدلهای یادگیری عمیق (Deep Learning) در سطح سازمانی، مستلزم توان پردازشی بالا، منابع ذخیرهسازی سریع و یکپارچگی نرمافزاری پیشرفته است. در سناریوهای واقعی، حجم عظیم دادههای آموزشی، نیاز به کلاسترهای محاسباتی قدرتمند دارد که بهطور همزمان از پردازندههای گرافیکی (GPU) نظیر NVIDIA A100/H100، شبکههای پرسرعت و حافظههای RAM حجیم بهره میبرند.

توسعهدهندگان و تیمهای داده، برای اجرای مدلهای LLM، پردازش زبان طبیعی (NLP)، بینایی ماشین و سیستمهای RAG، نیازمند محیطی هستند که نهتنها از نظر سختافزاری بهینه باشد، بلکه از منظر نرمافزاری نیز بهدرستی پیکربندی شده باشد — شامل CUDA، درایورهای GPU، کتابخانههایی مانند PyTorch/TensorFlow و ابزارهای استقرار مانند Docker و Kubernetes.

زمانی که بینشهای تولیدشده توسط هوش مصنوعی به تصمیمگیریهای تجاری سازمان گره میخورد، دیگر اجرای آزمایشگاهی کفایت نمیکند. ساخت، راهاندازی و نگهداری یک زیرساخت تولیدی (production-grade infrastructure) با عملکرد بالا، نیازمند تخصص فنی، اتوماسیون و نظارت دقیق است. بسیاری از سازمانها برای غلبه بر این چالش، به استفاده از سرورهای آمادهی هوش مصنوعی با طراحی ویژه روی میآورند که امکان استقرار سریع مدلها، مدیریت بهینه منابع و مقیاسپذیری در سطح enterprise را فراهم میسازد.